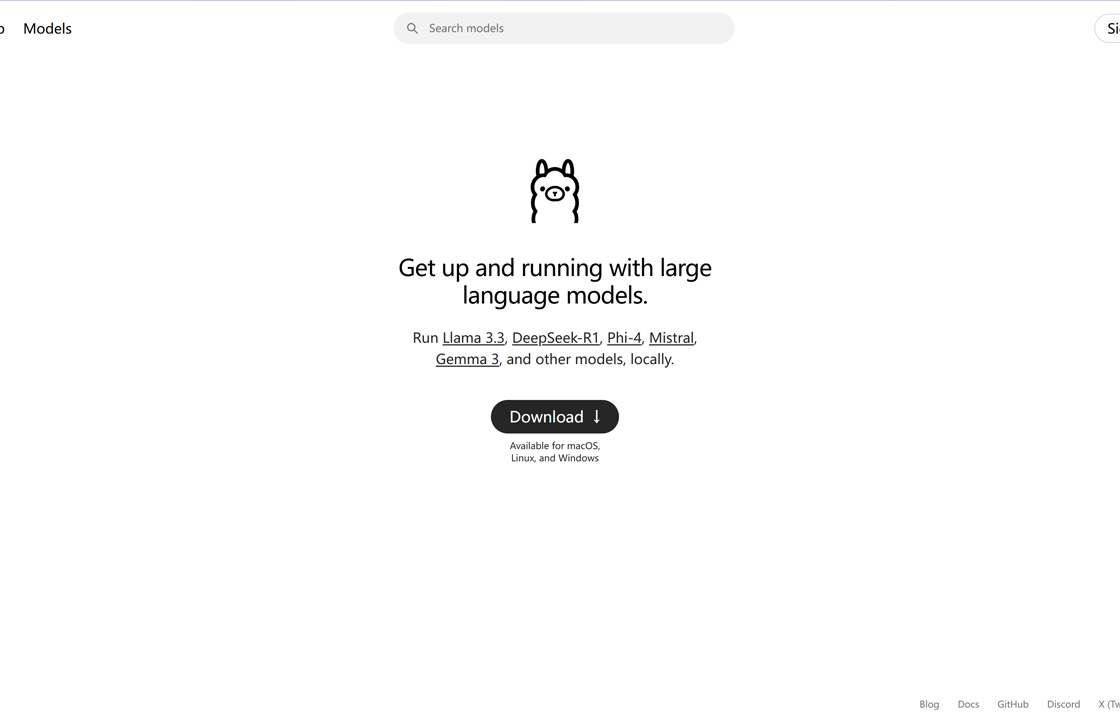

Ollama

Ollama 是一款开源工具,专为开发者、研究人员和创作者设计,允许在本地运行 Llama 3.3、DeepSeek-R1、Phi-4、Gemma 3 等大型语言模型(LLM),无需云端依赖。用户可通过命令行(ollama run)或 API(localhost:11434)进行对话、代码生成、文本分析和模型定制。其支持多模型并行处理、GPU 加速(CUDA)、模型管理(拉取、删除、版本控制)和工具调用(如 Llama 3.1),显著提升 50% 推理速度,广泛应用于本地 RAG、代码调试、内容创作和 AI 研究。

使用场景:

适合开发者、数据科学家和个人用户,用于本地生成代码、调试 Python、撰写文章、构建聊天机器人或研究 LLM 性能。

独特优势:

Ollama 成立于 2023 年,GitHub 星标超 137k(),服务全球开发者。其本地化设计确保 100% 数据隐私,免费支持 Llama、Mistral 等 50+ 模型,性能媲美云端 LLM(如 ChatGPT),推理成本为零。通过 MIT 许可与 OpenAI API 兼容,获 G2 2024 高评价(4.7 星,50+ 评论)。中文支持与低资源需求(4GB RAM 即可运行)特别适合中国开发者进行离线 AI 开发与出海实验。

操作体验:

用户直接访问 ollama.com,几秒内下载并运行 ollama pull llama3 启动模型。平台支持 Windows、macOS、Linux,提供 CLI、Python/JS 库和 Web UI(需 Open WebUI),操作直观高效。Ollama 提供 24/7 社区支持、文档(docs.ollama.com)和 Discord 频道,确保用户快速上手并优化模型体验。

网站流量情况

-

最新流量情况

月浏览量 40

平均访问时长 00:00:00

每次访问页数 1.2

跳出率 46%

-

流量来源

直接访问 1000

自然搜索 00:00:00

外链引荐 1.2

社交媒体 46%

展示广告 46%

-

截止目前所有流量趋势图

-

地理流量分布情况

中国 97.07%

美国 1.2%

新加坡 1.2%